Motivation:softmax-based contrastive loss의 단점

- 2번의 정규화:. image축단위로 softmax을 하고, text축단위로 softmax하기때문에, 2번연산함.

- 수치적으로 불안정 함: softmax의 $e^{z_{i}}$에서 $z_{i}$가 커지면 overflow가되어서 수치적으로 불안정함 (최대값을 빼서 사용하지만 여전히 불안정)

장점

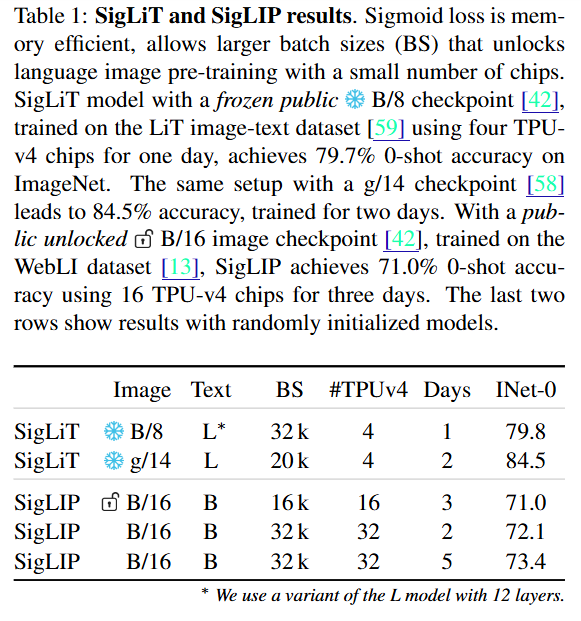

- Batch size: 16K 미만에서도 잘 동작함. (배치사이즈 커질수록 CLIP이랑은 비슷해지긴 함)

- 배치사이즈 키울 수 있음: symmetric하기 때문에.

Methods

- $x_{i}$: normalized image feature vector

- $y_{i}$: normalized text vector

- $t$: temperature scale. 초기값 log10

- $z_{i,j}$ : image, text label pair (origin이동일하면 1, 아니면 -1)

- $b$: bias (negative pair가 너무 많아서 bias을 추가) -10

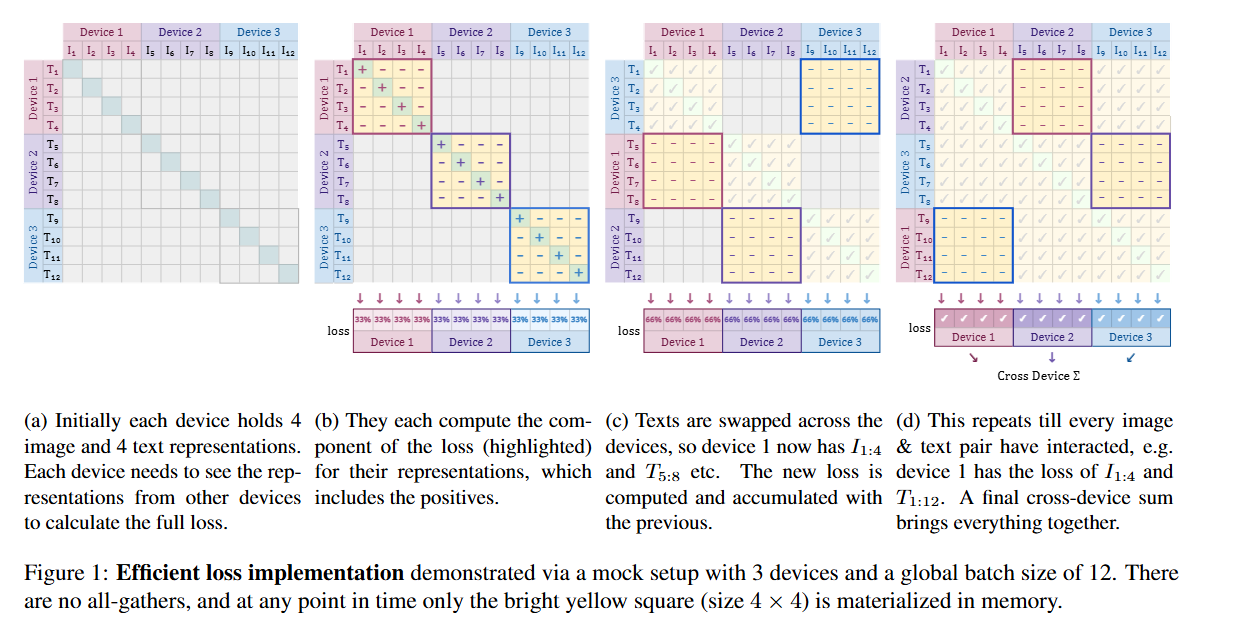

Data parallelism가능. 각 장치에서 순회하면서 전체유사도를 계산할수 있고, 마지막에 reduce + gather을 하면되어서 메모리효율적 (즉, all gather 필요없음)

반응형