요약

디스크에 저장없이 바이트범위만 획득하게하는 온라인패치는 패치의 배율, 좌표를 다양하게 할 수 있습니다. 온라인패치로 다양한 배율로 학습한 모델은 더 향상된 성능을 보여주었습니다. 그리고, 학습시, ImageNet을 파인튜닝하는게 FM모델을 만드는데 더 도움이 됩니다. 마지막으로, 데이터의 크기는 총 범위의 30% 정도면, 100%사용과 비슷한 성능을 기대할 수 있습니다. 그리고, 이 파이프라인은 eva라는 오픈소스로 공개되어있습니다.

Introduction

- 병리에서 자기지도학습알고리즘으로 대규모로 학습하는 사례가 많아짐.

- 어떤 방법으로 학습하고 적용해야, 효과적으로 large scale 모델을 학습할 수 있지 의문

- 이 연구에서는

- 학습/테스트 파이프라인을 제시 (eva)

- 온라인패치

- 하이퍼 파라미터, 초기화 전략, 배율를 조사

- 평가용 지표를 제시

- 학습/테스트 파이프라인을 제시 (eva)

=> eva은 오픈소스로 공개되어있습니다. https://github.com/kaiko-ai/eva?tab=readme-ov-file#quick-start

Methods

Online high-throughput loading of patches from WSIs

- 오프라인 패치: 학습전에 슬라이드이미지를 패치 단위로 디스크에 저장하고, 다시 불러오는 과정 -> 패치 사이즈/배율을 다양하게 저장하려면, 다양한 사이즈/배율의 N배 만큼 필요(=오버해드).

- 온라인 패치: Online patching 라이브러리를 만들어서, 패치를 학습단계에서, 좌표, 배율레벨에 따라서 쉽게 뽑는 과정 (=디스크에 저장할 필요없음)

+ 추가로, 전경만 찾기위해서 U-net기반의 segmentation 모델이 들어가있어, thumnail level에서 전경만찾음.

개발은 Zarr data source 을 이용 (Zarr 포맷을 이용하는 경우, 타일 의 바이트 범위를 추출하게되서 효율적)함. Online patching 라이브러리는 비동기적으로 네트워크나 Binary Large object을 부를 수 있음.

Results

1. 온라인 패치 효과 : 온라인패치는 타일링을 격자형이아니라 랜덤으로 뽑을 수 있어서 효과적

=> 같은 훈련데이터 숫자가 아니긴하지만... 어쩃든 더 나은 성능을 보여줬다는 것.

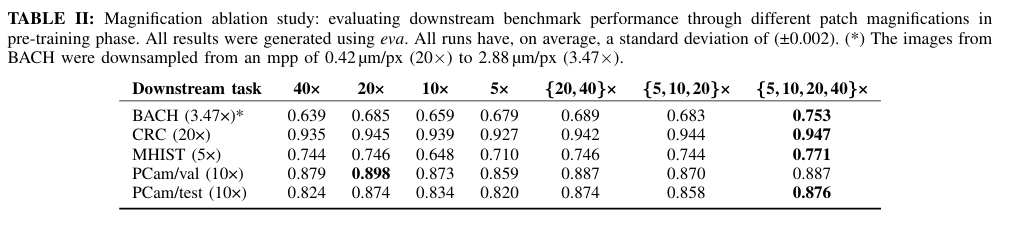

2. 다양한 배율을 학습한 모델이 강건함

3. ImageNet 사전 훈련 모델을 튜닝하는 것 효과

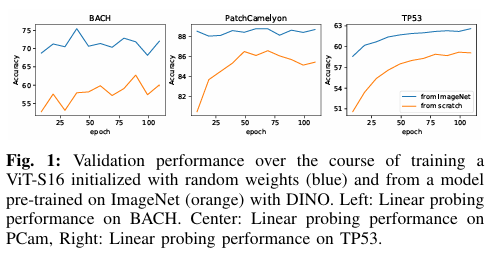

대부분 ImageNet의 사전학습 가중치를 쓰는건데, 연구결과에 담길만큼 특이한게 있냐?라고 생각할만한대요. 병리쪽에서는 ImageNet을 tuning할지, from scratch부터훈련할지 딱히 정해지지 않아, 학습시 고려사항이 되는데요. 이 연구에서는 이 고민을 해결해줄 결과를 같이 제시합니다. from ImageNet으로 학습하는게 더 수렴이 빠르다는 결론을 내어줍니다.

4. 학습 데이터 사이즈의 성능

- 학습 슬라이드를 몇장써야하냐의 문제입니다. 이 논문 결과는 아래의 연구결과(Karther lab)랑 동일한데요. 한 30%의 데이터만 있어도 전체 학습과 큰차이가 없다라는 것입니다.

- 패치 숫자를 1,000개 정도만 있어도 충분히 학습할 수 있다는 것도 보여줍니다,.

이 연구에서 ImageNet 사전 훈련 모델을 사용하는 이유는 단순히 기존의 방법을 따라가는 것이 아니라, 이를 통해 병리학적 데이터에서의 효과를 검증하고, 훈련 효율성을 높이며, 다른 연구와의 비교를 용이하게 하고, 사전 훈련의 한계와 개선점을 분석하기 위함입니다. 이러한 목적을 통해 연구의 신뢰성을 높이고, 병리학적 데이터에서 딥러닝 모델의 활용 가능성을 더욱 확장할 수 있습니다. 요약하면 아래와 같습니다.